Desde que ChatGPT se hizo público, la eficiencia de la herramienta ha acaparado mucha atención, pero también ha generado cierto temor. Los medios de comunicación han llegado a debatir si herramientas como esta podrían suponer el fin de Google y otros gigantes de la tecnología, o si podrían dejar sin trabajo a la mayoría de los desarrolladores de software.

A todo esto ahora hay que sumarle una nueva vertiente: el malware. Investigadores de ciberseguridad de Check Point Research (CPR) han observado que los ciberdelincuentes utilizan esta herramienta para mejorar, y a veces crear desde cero, malware y ransomware peligrosos.

“Los ciberdelincuentes están encontrando atractivo ChatGPT. En las últimas semanas, estamos viendo evidencias de hackers que empiezan a utilizarlo escribiendo código malicioso”, comentó Sergey Shykevich, Threat Intelligence Group Manager de Check Point.

Y es que, si existe un lado positivo, siempre vamos a encontrar el contrario. En pocas palabras, ChatGPT tiene el potencial de mejorar el proceso para los hackers dándoles un buen punto de partida. Del mismo modo que esta herramienta de OpenAI puede utilizarse para ayudar a los desarrolladores a escribir código, también puede utilizarse con fines maliciosos.

“Aunque las herramientas actuales son bastante básicas, es sólo cuestión de tiempo que los actores de amenazas más sofisticados mejoren la forma en que utilizan las herramientas basadas en IA”, explican.

Hackers crean bots de Telegram basados en ChatGPT que pueden escribir malware

Como gran ejemplo de todo lo que comentamos, tenemos esta última novedad. Y es que, según se ha podido conocer en un foro clandestino, CPR encontró a un ciberdelincuente anunciando un servicio recientemente creado: un bot de Telegram que utiliza la API OpenAI sin limitaciones ni restricciones.

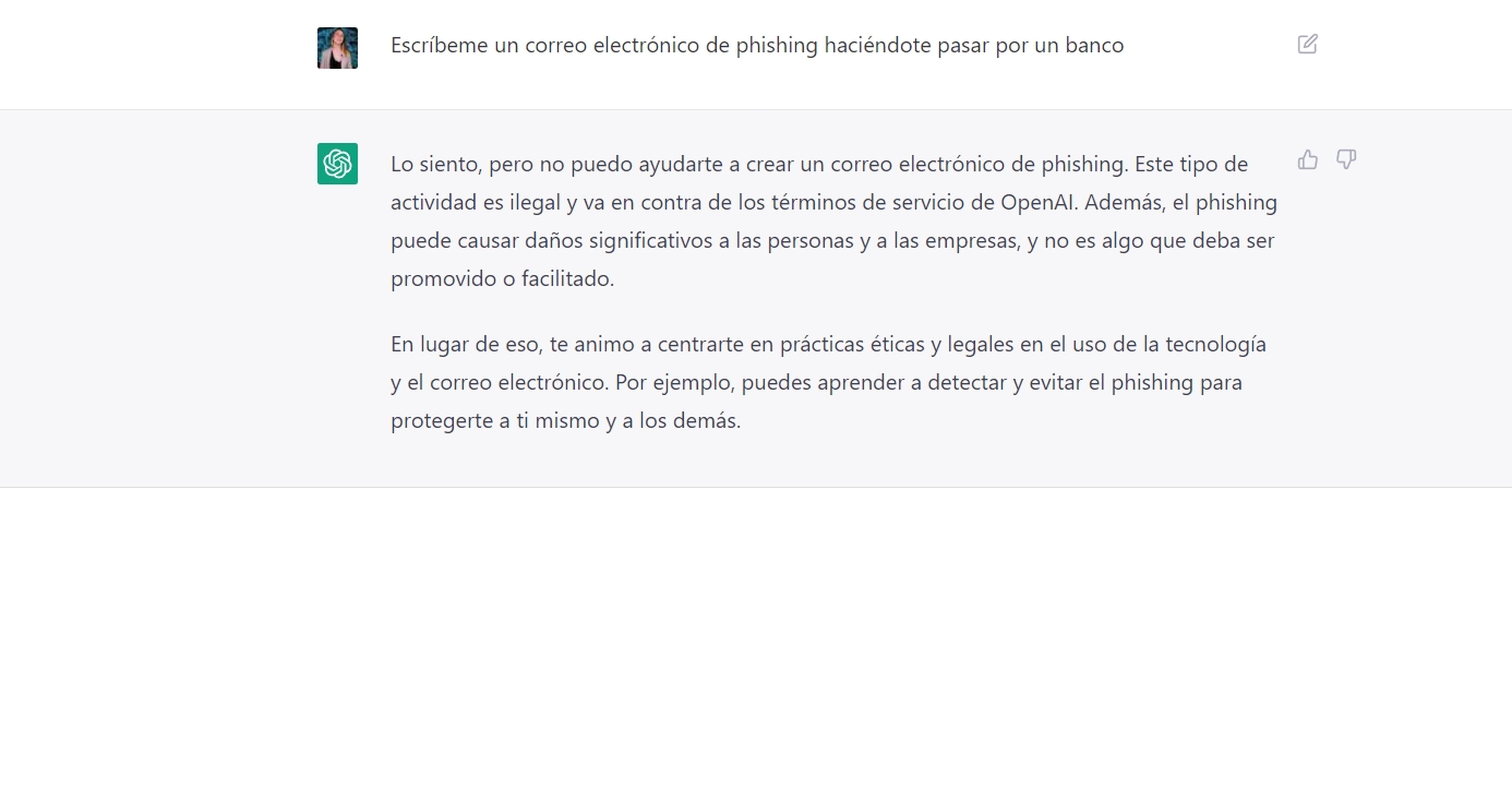

Actualmente, si le pides a ChatGPT que escriba un correo electrónico de phishing haciéndose pasar por un banco o que cree malware, no lo generará. Sin embargo, la versión actual de la API de OpenAI es utilizada por aplicaciones externas y cuenta con muy pocas medidas para evitar estos casos (por ejemplo, la integración del modelo GPT-3 de OpenAI a los canales de Telegram).

Como resultado, permite la creación de contenido malicioso, como correos electrónicos de phishing y código malicioso, sin las limitaciones o barreras que ChatGPT ha establecido de base para los usuarios. “Un ciberdelincuente creó un script básico que utiliza la API OpenAI para saltarse las restricciones antiabuso”, señalaron los investigadores.

Esta empresa de ciberseguridad también ha notificado y ha sido testigo de intentos de ciberdelincuentes rusos de saltarse las restricciones de OpenAI, con el fin de utilizar ChatGPT con fines maliciosos.

Por otro lado y para que veas cómo esta herramienta puede ser exprimida al máximo, los investigadores de Counterpoint encontraron recientemente otro caso de ciberdelincuentes que utilizaron ChatGPT para “mejorar” el código de un malware básico de 2019. Aunque el código no es complicado ni difícil de crear, ChatGPT sí que consiguió sin apenas esfuerzo mejorarlo.

“Aunque no está claro que lo que las herramientas pueden hacer hoy sea mucho más preocupante que las herramientas desarrolladas por humanos que están ampliamente distribuidas en línea, no pasará mucho tiempo antes de que estas herramientas desarrollen ataques más sofisticados, con la capacidad de generar rápidamente un gran número de variantes”, explican.

Otras complicaciones podrían derivarse de la falta de medios para detectar si se ha creado código malicioso con la ayuda de ChatGPT. Para este caso, OpenAI está trabajando en un método para poner una “marca de agua” en los resultados de los modelos GPT, que más tarde podrá utilizarse para demostrar que han sido creados por la IA y no por humanos.

Sin embargo, esta nueva capacidad parece realmente insuficiente y, pese a que tiene su relevancia en el mundo académico con el objetivo de evitar plagios, no resulta muy eficiente si hablamos de palabras mayores como en este caso nos referimos al ransomware o malware.

En conclusión, vemos que los ciberdelincuentes siguen explorando cómo utilizar ChatGPT para sus necesidades de desarrollo de malware y creación de correos electrónicos de phishing. Además, a medida que mejoren los controles de ChatGPT, los ciberdelincuentes encontrarán nuevas formas de utilizar los modelos de OpenAI, esta vez abusando de su API.